Протокол совещания как вести: Материалы не найдены • Asana

Автоматическая генерация протоколов совещаний / Хабр

Вступление

Привет! Меня зовут Максим Бондарев, я работаю младшим разработчиком в компании Digital Design и заканчиваю обучение на математико-механическом факультете СПбГУ. В рамках своей исследовательской работы я занимался решением задачи по автоматической генерации протоколов совещаний в составе команды научной лаборатории (aka Конструкторское Бюро) под руководством Максима Панькова. Что из этого получилось, и над чем еще предстоит поработать, расскажу в этой статье.

SumMeet

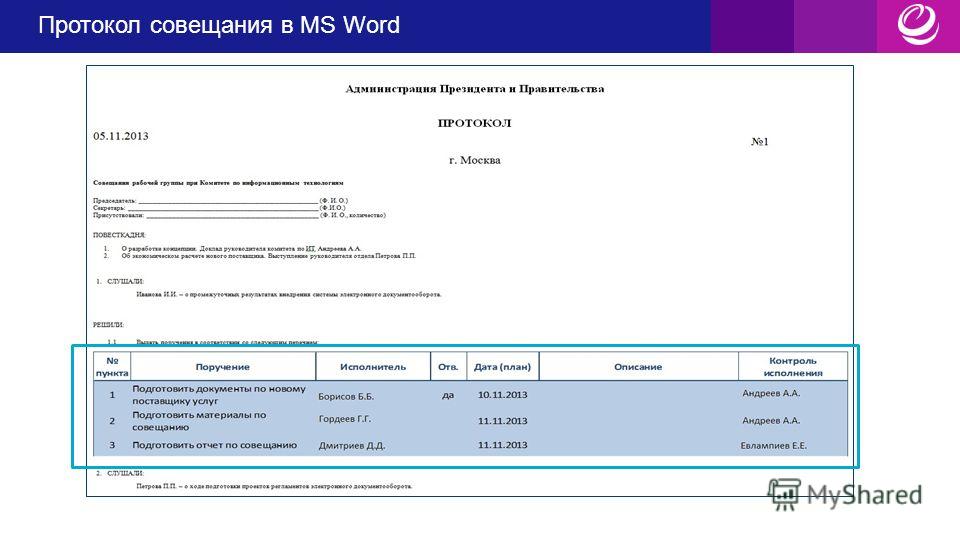

В крупных организациях в течение одного дня могут проходить десятки собраний, в процессе которых формируется множество бумаг, в том числе протоколов. Это осложняет работу как самих участников совещаний, так и секретарей-референтов: материалы по итогам заседаний формируются несколько дней, замедляется исполнение задач и поручений. Как следствие – недовольные руководители и сотрудники, замученные и уставшие секретари. А если совещание проходит без секретаря, то часть информации может быть просто утеряна.

Для решения этой проблемы мы с коллегами работаем над виртуальным ассистентом для подготовки итогов совещаний — SumMeet. Он может расшифровать аудиозапись встречи и выделить ключевые моменты по итогам онлайн и оффлайн собраний при помощи технологий искусственного интеллекта.

Формирование итогов происходит в 3 этапа:

Распознавание речи в аудиозаписи совещания

Разбиение транскрипта по спикерам

Извлечение из полученной стенограммы наиболее важных моментов совещания

В этой статье мы сфокусируемся на нашем подходе к реализации третьего этапа.

О задаче

Автоматическое формирование итогов собрания можно назвать задачей суммаризации. Существует два разных подхода к автоматической суммаризации: экстрактивный и абстрактивный.

Экстрактивная суммаризация направлена на выявление важной информации, ее извлечение и группирование для формирования краткого резюме.

Абстрактивная суммаризация предполагает генерацию новых предложений на основе информации, извлеченной из корпуса.

Задача была нетривиальной, и сначала мы отдали предпочтение экстрактивному подходу к суммаризации. То есть нам нужно было предсказывать, к какому классу относится каждая реплика из стенограммы. В терминах машинного обучения эту задачу можно представить как классификацию текстов.

В нашем случае, изучив итоги, составленные вручную коллегами, мы приняли решение остановиться на трёх классах, а именно «Дальнейшие шаги», «Основные моменты» и «Остальное». Класс «Дальнейшие шаги» включает в себя: задачи, призывы к действию и планы, а в класс «Основные моменты» попадают скорее формулировки обсуждаемых вопросов, идеи и решения, принятые на собрании.

Данные

СОЗДАНИЕ СОБСТВЕННОГО ДАТАСЕТА

Чтобы решать задачу классификации, необходимы размеченные данные. Готовых корпусов для суммаризации диалогов на русском языке нет. Поэтому мы начали записывать собственные митинги, используя для получения стенограммы сторонние ASR (Automatic Speech Recognition) решения. Также на этом этапе происходит разбиение стенограммы на высказывания.

Также на этом этапе происходит разбиение стенограммы на высказывания.

Разметка митингов производилась силами двух человек (чаще всего это один из участников митинга) и происходила примерно так: каждое высказывание с митинга относили к одному из классов. Для разметки использовали инструмент для аннотации с открытым исходным кодом — doccano.

АУГМЕНТАЦИЯ ДАННЫХ

Разметка митингов — достаточно трудоемкий процесс, а данные для нас очень важны. Поэтому мы также пытались расширить датасет другими способами.

ПЕРЕВОД

Один из вариантов борьбы с нехваткой данных для обучения — автоматический перевод размеченного англоязычного датасета. На английском языке существует как минимум три корпуса для суммаризации митингов: ICSI, AMI и QMSum. Мы решили, что один из этих корпусов можно попробовать перевести с помощью Google-переводчика и добавить к нашим данным. Выбор пал на AMI Corpus, как на самый популярный из имеющихся.

Мы сравнивали результаты моделей на двух датасетах. Один из них включал только наши митинги, во втором присутствовали наши митинги и переведенные. При обучении только на наших митингах мы получали значение F1-меры в среднем на 15% выше, чем при обучении с использованием AMI Corpus. Возможно, это связано с другой структурой совещаний, а также с ошибками переводчика.

Один из них включал только наши митинги, во втором присутствовали наши митинги и переведенные. При обучении только на наших митингах мы получали значение F1-меры в среднем на 15% выше, чем при обучении с использованием AMI Corpus. Возможно, это связано с другой структурой совещаний, а также с ошибками переводчика.

АРХИВНЫЕ ИТОГИ ВСТРЕЧ

До того как мы начали записывать свои митинги, коллеги отправляли итоги совещаний друг другу на почту. Мы решили, что их также можно собрать и попробовать использовать в обучении. Эксперименты показали, что значение F1-меры увеличилось примерно на 10% после добавления «архивных итогов встреч» в обучающую выборку. Они также использовались при обучении актуальной модели.

АВТОМАТИЧЕСКАЯ РАЗМЕТКА

Также были проведены эксперименты по автоматической разметке. Мы использовали написанное человеком резюме, и с помощью него пытались автоматически собрать экстрактивное резюме. Делали мы это с помощью сравнения значений метрики ROUGE-1 каждой реплики из стенограммы с каждым пунктом из протокола встречи, составленного человеком. Такая разметка сильно расходилась с ручной разметкой аннотаторов, и добавление этих данных не дало положительного влияния на результаты модели.

Такая разметка сильно расходилась с ручной разметкой аннотаторов, и добавление этих данных не дало положительного влияния на результаты модели.

СОСТОЯНИЕ ДАТАСЕТА В ДАННЫЙ МОМЕНТ

400 записанных совещаний (аудиодорожка + стенограмма)

72 совещания с написанным участником протоколом (аудиодорожка + стенограмма + резюме)

28 размеченных совещаний (аудиодорожка + стенограмма + резюме + разметка)

Модели

В этом разделе хотелось бы рассказать о подходах, которые мы пробовали для решения нашей задачи. Подходы разбили на два класса: классические и нейросетевые.

КЛАССИЧЕСКИЕ МЕТОДЫ

Классические модели иногда показывают себя лучше, чем нейронные сети, особенно в случаях когда данных для обучения слишком мало. Именно по этой причине мы не могли их не попробовать.

BOW + Naive bayes

Для начала мы взяли самый простой статистический подход, Bag-of-words с Naive bayes, чтобы использовать его в качестве бейзлайна.

Модель Bag-of-words проста: она строит словарь из корпуса высказываний и подсчитывает, сколько раз в каждом высказывании встречается каждое слово. В результате все высказывания представляются вектором, длина которого равна количеству слов в словаре.

Наивные байесовские классификаторы — это линейные классификаторы, которые известны своей простотой и в то же время эффективностью. Вероятностная модель наивных байесовских классификаторов основана на теореме Байеса, а прилагательное наивный исходит из предположения, что признаки в наборе данных взаимно независимы.

BOW(TF-IDF) + SVM и Logistic Regression

Частота использования слов — не лучшее представление текста. Какие-то слова могут встречаться в высказываниях очень часто, но не нести смысла, например, предлоги. Для решения этой проблемы существует расширенный вариант bag-of-words, в котором вместо простого подсчета используется TF-IDF («частота слова — обратная частота документа»). В нем соответствующее слову значение увеличивается пропорционально частоте в текущем высказывании, но также уменьшается пропорционально количеству высказываний, в которых встречается слово.

В нем соответствующее слову значение увеличивается пропорционально частоте в текущем высказывании, но также уменьшается пропорционально количеству высказываний, в которых встречается слово.

В качестве классификатора мы попробовали один из популярнейших, используемых для текста — SVM и Logistic Regression.

Метод опорных векторов (Support Vector Machine) — это простой алгоритм машинного обучения, используемый для классификации и регрессии.

Основная идея метода заключается в построении гиперплоскости, разделяющей объекты выборки оптимальным способом. Алгоритм работает на предположении: «чем больше расстояние между разделяющей гиперплоскостью и объектами разделяемых классов, тем меньше будет средняя ошибка классификатора».

Логистическая регрессия (Logistic Regression) — модель машинного обучения, используемая для задачи классификации. Логистическая регрессия является частным случаем линейной регрессии: для прогнозирования вероятности принадлежности каждому из классов она использует взвешенную линейную комбинацию входных признаков и передает их через сигмовидную функцию.

Нейронные сети

RNN

RNN (Recurrent neural network) — вид нейронных сетей, элементы которой связаны друг с другом последовательно. Принцип работы рекуррентных сетей очень похож на естественный для человека способ обработки текста: подобно человеку они «читают» последовательность слов одно за другим.

Мы используем усовершенствованную версию RNN — LSTM. Она лучше справляется с главной проблемой рекуррентных сетей, а именно с «забыванием» более ранних фрагментов текста из-за затухания градиентов.

По причине того что у нас небольшой датасет, он может не очень подходить для обучения RNN с нуля. Поэтому мы решили попробовать инициализировать embedding-слои модели предобученными весами Word2Vec.

Word2Vec — это метод для построения векторных представлений слов на основе неразмеченных данных. Word2Vec каждому уникальному слову в корпусе сопоставляет некоторый вектор, обычно размерностью порядка 100. В получившемся векторном пространстве слова, имеющие общий контекст в корпусе, располагаются рядом друг с другом. Для обучения Word2Vec существует 2 разных подхода: предсказывать контекст по каждому слову (Skip-gram), или предсказывать каждое слово по контексту (Continuous Bag-of-Words).

Для обучения Word2Vec существует 2 разных подхода: предсказывать контекст по каждому слову (Skip-gram), или предсказывать каждое слово по контексту (Continuous Bag-of-Words).

Мы использовали для инициализации весов embedding-слоев предобученные вектора FastText. FastText — это расширение Word2Vec, которое работает на уровне «подслов» (символьных n-грамм), что, в свою очередь, позволяет лучше интерпретировать редкие и неправильно распознанные слова.

BERT-based

BERT

BERT — это языковая модель, основанная на энкодере из архитектуры Transformer. Она превзошла предыдущие SOTA методы во многих NLP задачах, а где-то и человеческие показатели.

В отличие от прежних методов построения векторных представлений, BERT предоставляет контекстно-зависимые представления. Например, Word2vec генерирует единственное представление для одного слова, даже если слово многозначное, и его смысл зависит от контекста. Использование BERT же позволяет учитывать окружающий контекст предложения и генерировать различные представления.

DistillBERT

Помимо обычного BERT мы решили попробовать модель поменьше. Для этого мы использовали DistillBERT, полученный методом дистилляции. Дистилляция использует большую модель в качестве учителя для меньшей модели, которая пытается повторить ее результаты.

RoBERTa

Также в качестве более новой альтернативы BERT мы попробовали модель RoBERTa от Facebook. RoBERTa основана на той же архитектуре, но отличается методикой обучения и затраченными вычислительными мощностями.

Чтобы улучшить процедуру обучения, RoBERTa удаляет задачу предсказания следующего предложения (Next Sentence Prediction) из предварительного обучения BERT и вводит динамическое маскирование, так что маскируемый токен меняется в течение эпох обучения.

Все три варианта моделей мы дообучили под нашу задачу на собственных данных, взяв их предварительно обученные версии для русского языка.

Ссылки на предобученные BERT-based модели, которые мы использовали:

Distilrubert-base-cased-conversational (DeepPavlov)

Rubert-base-cased-sentence (DeepPavlov)

Distilrubert-tiny-cased-conversational (DeepPavlov)

Rubert-base-cased (DeepPavlov)

Rubert-base-cased-conversational (DeepPavlov)

RuRoberta-large(Sber)

RuBert-base (Sber)

RuBert-large (Sber)

RuBert-large (Sber)

Результаты экспериментов

Результаты проведенных экспериментов с перечисленными выше моделями представлены в табличке ниже. Модели упорядочены по F1-мере (макро и без учета фонового класса) от лучшего результата к худшему. Данную метрику использовали из-за сильного дисбаланса классов.

Модели упорядочены по F1-мере (макро и без учета фонового класса) от лучшего результата к худшему. Данную метрику использовали из-за сильного дисбаланса классов.

Лучшей оказалась модель DistillBERT от DeepPavlov, которая была предобучена на разговорной речи в большей степени на социальных сетях и субтитрах к фильмам.

Также мы провели исследование, в ходе которого участников митингов попросили сравнить протокол, составленный моделью, с протоколом, составленным человеком, оценив важность каждого из пунктов протокола. В процессе исследования использовалась модель, которая сейчас занимает только 7 строчку в таблице. И участники в среднем оценивали важность добавленного итога совещания на 3.5 из 5.

Проблемы экстрактивной суммаризации

Результаты экспериментов нас порадовали, но экстрактивный подход сам по себе не позволяет достичь уровня качества, сравнимого с человеческим. Здесь хорошо подходит комментарий одного из участников исследования по оценке качества резюме: «Почти каждый фрагмент из итогов необходимо отредактировать перед тем, как занести его в протокол». И вызвано это следующими тремя проблемами:

И вызвано это следующими тремя проблемами:

Реплика вырвана из контекста. Итог может не включать в себя некоторую важную информацию, потому что о ней говорилось либо в другое время совещания, либо только подразумевалось.

Ошибки ASR. Произнесенная информация может сильно исказиться из-за ошибок распознавания речи.

Устная речь отличается от письменной. Как мы заметили, произнося свои мысли на митингах, люди формулируют их совершенно иначе, чем при записи в протокол.

Если все перечисленные проблемы встречаются в одном пункте протокола, мы получаем «набор слов», по которому не всегда можно понять, о чем именно говорил человек.

Планы

ГОЛОСОВОЙ ПОМОЩНИК

В связи с выше перечисленными проблемами мы решили, что стоит добавить возможность явно обращаться к модели. Такую функциональность мы подсмотрели у одного из иностранных конкурентов.

На совещании человек может произнести «Саммит, запиши» или «Саммит, поставь задачу», после этого сказать важную информацию, которую ему не хотелось бы потерять, и, наконец, завершить свою мысль словами «Саммит, спасибо», чтобы дать понять, где именно она заканчивается.

Если участник митинга попросил ассистента что-то записать, это попадет в отдельный блок протокола, и человек может быть уверен, что эта информация не будет утеряна. Если же на совещании попросили поставить задачу, а также произнесли имя исполнителя и срок выполнения, то её можно отправить в задачник автоматически с использованием Named Entity Recognition. На данный момент мы уже тестируем обращение к модели на наших митингах.

Этот подход помогает нам решить проблемы №1 и №3 из предыдущего раздела. Самое интересное, что решаются они не из-за улучшения модели (модель используется та же), а скорее из-за того, что спикер начинает формулировать свои мысли иначе после обращения к боту.

Главная проблема данного подхода в том, что не все форматы совещаний допускают обращения к боту по ходу заседания, и не все люди готовы менять свое поведение. Кроме того, мы не избавляемся с помощью этого подхода от ошибок ASR.

Кроме того, мы не избавляемся с помощью этого подхода от ошибок ASR.

АБСТРАКТИВНАЯ СУММАРИЗАЦИЯ

В то же время мы начали работы по применению абстрактивного подхода к суммаризации. На данный момент мы используем предобученную модель T5 от Сбера для перефразирования полученных с помощью экстрактивного подхода минуток. Протоколы стали более читаемыми, но их информативность все еще сильно зависит от качества экстрактивной суммаризации.

С помощью абстрактивной суммаризации мы способны решить все проблемы, перечисленные в прошлом разделе, но пока наши эксперименты находятся на начальном этапе и требуют доработок.

У нас есть много дальнейших планов по решению этой задачи. Приведу несколько примеров:

Перевод англоязычных корпусов под задачу абстрактивной суммаризации.

Адаптация новостного датасета под формат митингов (как в HMNet).

Продолжение сбора своего датасета под задачу абстрактивной суммаризации.

Дополнительные эксперименты по перефразированию экстрактивных минуток.

Дообучение end-to-end моделей, таких как BART и T5.

Декомпозиция задачи на более мелкие части, такие как разбиение митинга на топики, их классификация, и только уже потом суммаризация этих частей.

Заключение

Разработка решения еще ведется, поэтому мы будем очень рады услышать любые советы, предложения, а также критику. Постараемся по мере продвижения выкладывать новые статьи по суммаризации и по другим аспектам нашего продукта.

Как делать классные протоколы совещаний

- 14 ноября 2022 года

- 6:43 утра

На совещаниях могут происходить удивительные вещи. Будь то удаленные, гибридные или личные встречи, именно на них часто формируются, инкубируются и воплощаются в жизнь невероятные идеи. следующей — большой — вещи! Знание того, как вести протокол совещания, очень важно, если вы хотите быть уверенными, что ни одно из этих волшебств не будет утеряно.

следующей — большой — вещи! Знание того, как вести протокол совещания, очень важно, если вы хотите быть уверенными, что ни одно из этих волшебств не будет утеряно.

Что вы найдете в этом руководстве по протоколам собраний

Однако, подобно глубокому разговору с друзьями поздно вечером, эти маленькие жемчужины озарения, эти искры творчества и гениальности… они склонны теряться в дебрях нашего разума. Наша память ненадежна — особенно когда речь идет о сложной, технической или детальной информации. Не записав ключевые выводы или пункты действий на встрече, вы рискуете потерять все эти плодотворные идеи.

Это никому не нужно. Отсутствие документального оформления собрания — это упущенная возможность собирать, хранить и делиться информацией. Вам нужны протоколы собраний, и хорошие протоколы. Самое главное — вам нужны отличные методы ведения протокола для совещания!

Попрощайтесь с записями в бумажном блокноте, чтобы потом потерять их навсегда. Попрощайтесь с тем, что вы фиксируете случайные фрагменты информации, но забываете контекст или не знаете, как поделиться полученными знаниями в организации.

Попрощайтесь с тем, что вы фиксируете случайные фрагменты информации, но забываете контекст или не знаете, как поделиться полученными знаниями в организации.

Мы расскажем, как вы можете делать заметки о совещаниях, которые:

- Богатый контекст

- Ясно как день

- Эффективный захват

- С возможностью поиска

- Связь с собранием

- Прозрачный

- Демократизированный

- Мгновенный доступ для всех

Но прежде чем мы начнем…

Что такое протокол собрания?Протокол собрания — это официальный письменный отчет о том, что обсуждалось и решалось на собрании. Они помогают обеспечить единство мнений как участников собрания, так и отсутствующих заинтересованных сторон. Протокол собрания должен содержать краткое изложение принятых решений, сделанных выводов и полученных выводов. Самое главное, необходимо задокументировать пункты действий, вытекающие из встречи.

Звучит достаточно просто, верно? Так и есть. .. но только если вы знаете, как правильно вести протокол собрания.

.. но только если вы знаете, как правильно вести протокол собрания.

Традиционно одному человеку в компании обычно поручалось вести протокол собрания. Этот человек должен быть пассивным слушателем и эффективно печатать. Он собирал записи, печатал их в правильном формате, а затем отвечал за их передачу соответствующим заинтересованным сторонам.

В наши дни любой человек может быть призван нести ответственность за ведение протокола собрания. Технологии упростили и улучшили практику ведения протоколов собраний. Хотя некоторые до сих пор предпочитают оформлять протоколы заседаний рукописными записями, сейчас проще, чем когда-либо, вести протоколы заседаний онлайн, например, с помощью приложения Zoom notetaker или дополнения Google Meet notetaker.

Посмотреть это сообщение на Instagram

A post shared by tl;dv (@tldview)

Главное, что нужно помнить при работе с протоколами, — это контекст, ясность, точность и прозрачность. Таким образом, ни один из важных выводов не будет потерян, и не возникнет перекрещивания проводов по поводу того, что было сказано и что имелось в виду.

Таким образом, ни один из важных выводов не будет потерян, и не возникнет перекрещивания проводов по поводу того, что было сказано и что имелось в виду.

При составлении протокола важно быть как можно более кратким. Это означает, что вы должны включить только ключевые моменты, которые обсуждались на встрече, и опустить все, что не относится к делу.

Протоколы совещаний должны облегчать любому человеку возможность в считанные минуты просмотреть то, что обсуждалось, тем самым напоминая себе о действиях и выводах.

Как вести протокол личного собранияНа физических совещаниях ведение записей может быть немного сложнее. Там редко есть запись, к которой можно вернуться, и вы не сможете воспользоваться программным обеспечением для виртуальных встреч, которое поможет делать заметки в Zoom, Google Meet или MS Teams. Но не волнуйтесь! Существует множество советов, которые помогут вам вывести протоколы личных встреч на новый уровень.

Чтобы облегчить задачу, мы составили пошаговое руководство:

1. Начните с записи основных сведений: кто, что, где и когда

Начните с записи основных сведений: кто, что, где и когдаЭто может показаться очевидным, но важно сначала записать основную информацию. Это поможет придать протоколу определенную структуру и не забыть ни одной ключевой детали. Запишите, кто присутствует на собрании, дату и время проведения собрания, а также место проведения собрания.

2. Запишите краткий обзор того, что обсуждалось на встречеОпять же, это может показаться необязательным, но важно записать краткий обзор основных тем, которые обсуждаются на собрании. Скопируйте официальную повестку дня и не забудьте добавить информацию о любых обсуждаемых вопросах, не входящих в повестку дня. Возможно, вы захотите начать протокол собрания с изложения цели собрания — почему обсуждаются эти темы и какие цели должны быть достигнуты к концу собрания?

3. Запишите любые действия, которые необходимо предпринять по итогам встречиЭто самая важная часть ведения протокола, поскольку она гарантирует, что все знают, что и когда должно быть сделано. Записывая пункты действий и сроки, будьте как можно более конкретными и убедитесь, что вы можете поручить каждый пункт конкретному человеку или команде.

Записывая пункты действий и сроки, будьте как можно более конкретными и убедитесь, что вы можете поручить каждый пункт конкретному человеку или команде.

Если в ходе встречи прозвучали какие-то особенно запоминающиеся или важные замечания, обязательно дословно запишите их в протокол. Это поможет передать суть обсуждения, выразив мысли словами участников.

5. Редактирование и форматирование протокола по мере необходимостиПосле того как вы записали всю вышеперечисленную информацию, настало время отредактировать и оформить протокол в соответствии с требованиями. Возможно, вы захотите воспользоваться шаблонами протоколов собраний (мы даже добавили их в нижнюю часть этой статьи!).

Обязательно вычитайте протокол собрания на предмет опечаток и ошибок и оформите его так, чтобы его было легко читать и понимать. Если вам нужно перепроверить какую-либо деталь, спросите кого-нибудь из присутствовавших на собрании — но делайте это быстро, пока это не вылетело у них из головы.

И это все!

Затем вы можете сохранить, распечатать или поделиться протоколом собрания по мере необходимости. Где бы вы ни сохраняли протоколы, вы должны делать это относительно организованно и, возможно, установить соглашение об именовании, чтобы нужные протоколы можно было найти в нужное время (всем, кому необходимо их увидеть).

Для любых встреч, которые проводятся после этой первоначальной встречи, убедитесь, что вы предоставили участникам протокол предыдущей встречи, чтобы у них было напоминание о том, что произошло на последней встрече и что необходимо проверить и охватить на этой последующей встрече.

Ведение протокола виртуального собранияДля виртуальной встречи также можно следовать этим шагам, но, к счастью, есть гораздо более простой способ!

Нет смысла поручать одному человеку писать подробный отчет о виртуальной встрече, когда весь разговор записывается. Это просто неэффективное использование времени. Если позволить всем участникам записывать важные для них выводы и пункты действий в ходе виртуальной встречи, то не будет риска, что что-то будет упущено.

Вот где пригодится такой инструмент, как tl;dv приходит на помощь. Этот бесплатный и простой инструмент для проведения совещаний интегрируется в платформу Zoom или Google Meet и позволяет любому участнику совещания записывать свои собственные протоколы в интерфейсе tl;dv . Этот демократичный стиль ведения протокола совещания также позволяет отмечать конкретных участников, чтобы они получали уведомления по электронной почте и точно знали, какую часть записи следует просмотреть.

Эта «заметка» затем становится «ярким моментом» или «временной меткой», которую ваши коллеги могут позже просмотреть в записи разговора. Протоколы совещаний с временными метками работают как видеозакладки, экономя время каждого, позволяя мгновенно перейти к наиболее важным частям записанного совещания.

Преимущество заключается в том, что у вас будет не просто задокументированный протокол собрания — у вас будет сопроводительное видео и стенограмма, которые обогатят контекст. А если вы захотите внести изменения в протокол собрания, вы сможете легко сделать это из своей библиотеки tl;dv , удалив, добавив или обновив протокол собрания с временной отметкой по мере необходимости!

tiktok.com/@kathreensocials/video/7161805463938403610″ data-video-id=»7161805463938403610″> @kathreensocials pov вы назначены для записи минут #meetinghacks #worktok #corporateslave #tldv ♬ Made You Look — Meghan Trainor

Так что если вам нужен конспектирование Google Meet или Zoom notetaker, tl;dv помогут в мгновение ока.

Пользователям Google Meet достаточно установить расширениеtl;dv Chrome и участвовать во встрече в обычном режиме. Расширение начнет запись и расшифровку сразу после того, как вы нажмете кнопку «Запись» — или вы можете настроить параметры так, чтобы определенные типы встреч всегда записывались автоматически.

Для пользователей Zoom необходимо сначала начать запись собрания, а затем добавить tl;dv в качестве участника. Расшифровка начнется автоматически и станет доступна для просмотра или загрузки сразу после окончания собрания.

Кроме того, автоматическое ведение заметок и расшифровка имеют целый ряд дополнительных преимуществ. Помимо того, что они позволяют не упустить ни одного момента, они полностью демократизируют весь процесс. Никому не придется нести бремя единоличной ответственности за заметки — и ведение записей будет прозрачным на протяжении всего совещания. Возможно, лучше всего то, что вам больше не нужно беспокоиться о потере записей после совещания.

Никому не придется нести бремя единоличной ответственности за заметки — и ведение записей будет прозрачным на протяжении всего совещания. Возможно, лучше всего то, что вам больше не нужно беспокоиться о потере записей после совещания.

Помимо обеспечения точной транскрипции, tl;dv позволяет прикреплять к записанному разговору протоколы совещаний в виде временных меток.

Это невероятно полезно, если вам нужно вернуться к определенному моменту обсуждения или поделиться с другими конкретным моментом. Еще лучше то, что для добавления таких записей не нужно быть администратором или начальником — все имеют доступ к этой функции и могут создавать свои собственные временные метки для актуальности и контекста. Это работает как для временные метки записи Zoom и временных меток Google Meet.

Временные метки будут видны всем участникам совещания в режиме реального времени. Чтобы просмотреть их впоследствии, просто перейдите по ссылке на запись собрания. Временные метки будут отображаться рядом с расшифровкой, что позволит легко пролистать ее и найти нужный раздел.

Чтобы просмотреть их впоследствии, просто перейдите по ссылке на запись собрания. Временные метки будут отображаться рядом с расшифровкой, что позволит легко пролистать ее и найти нужный раздел.

Вы добавляете временные метки вручную и можете делать это в любое время, когда хотите отметить конкретный вопрос или выделить что-то, к чему стоит вернуться на другой встрече. Для этого просто введите протокол собрания или заметки в интерфейс tl;dv Highlights. Временная метка будет добавлена к протоколу встречи и будет работать как видеозакладка.

МеткиТегирование — это еще одна замечательная функция tl;dv , которая позволяет выделить важные части собрания для других. Это особенно полезно, если вам нужно поделиться протоколом с кем-то, кто не смог присутствовать на встрече.

Чтобы отметить кого-то из участников совещания, просто введите @ в интерфейсе tl;dv , а затем имя коллеги, которого вы хотите зациклить. Вы также можете добавить эти метки в ретроспективе, перейдя к определенному моменту записи, нажав кнопку «Добавить метку времени» и выполнив то же действие.

Неплохо было бы написать короткий комментарий, в котором кратко описать, почему необходим их вклад или осведомленность. Ваш коллега получит электронное письмо, в котором он будет предупрежден о том, что его отметили в конкретном моменте разговора. Отмеченный раздел будет выделен в протоколе собрания, что облегчит его поиск для других.

Многоязычныйtl;dv может переводить заметки на более чем 20 языков. Это облегчает проведение международных деловых встреч, так как каждый может получить доступ к записям на своем языке.

Асинхронный дружественныйОдно из ключевых отличий ведения протокола собрания в цифровом формате, например, с помощью tl;dv, заключается в отсутствии необходимости присутствия на собрании. Вам не обязательно присутствовать на собрании, чтобы вести протокол. Вы можете легко добавить протокол собрания в ретроспективе.

Если двум заинтересованным сторонам нужно быстро провести совещание, а другие не могут прийти — не беда! Запись и стенограмма позволят ничего не потерять.

tl;dv интегрируется с рядом популярных инструментов и CRM, таких как Slack, Google Docs, HubSpot и Salesforce. Это позволяет быстро и легко делиться протоколами совещаний с другими людьми без необходимости добавлять их вручную.

Чтобы настроить интеграцию, просто нажмите на кнопку «Интеграции» в интерфейсе tl;dv и выберите инструмент, который вы хотите использовать. Следуйте инструкциям, чтобы подключить tl;dv к вашему аккаунту, и все готово!

Существует множество преимуществ интеграции инструмента для проведения видеосовещаний и составления протоколов с CRM-системами, такими как HubSpot и Salesforce, например:

Экономия времениВам больше не придется планировать и посещать несколько совещаний, чтобы получить информацию от разных членов команды, работающих над одним и тем же проектом. С помощью интеграции видеосовещаний и протоколирования tl;dv вы можете просматривать запись всего совещания вместе с ключевыми моментами и пунктами действий в одном месте. Это означает, что вы можете сэкономить время, не посещая ненужные встречи и быстро получая обновления, когда это необходимо.

Это означает, что вы можете сэкономить время, не посещая ненужные встречи и быстро получая обновления, когда это необходимо.

Это также означает, что вам не нужно тратить кучу времени на составление заметок или перенос деталей в CRM. Простым щелчком мыши ваши видеоклипы и временные метки попадают в вашу платформу collanborative, где вы и ваши сотрудники могут в любое время получить доступ к звонку, стенограмме и временным меткам.

Лучшее обслуживание клиентовБлагодаря видеовстречам и протоколам, хранящимся вместе с данными о клиентах в вашей CRM, ваша служба поддержки клиентов сможет обеспечить лучший опыт для своих клиентов. У них под рукой будет вся необходимая информация, чтобы отвечать на любые вопросы, эффективно отслеживать ситуацию, решать проблемы и в целом обеспечивать пятизвездочное обслуживание.

Повышение прозрачности и подотчетностиИнтегрировав видеосовещания и протоколирование в CRM-систему, вы сможете повысить прозрачность и подотчетность в своей организации. Это связано с тем, что все члены команды смогут видеть запись совещания, что облегчает последующие действия. Кроме того, такая интеграция позволит вам отслеживать ход выполнения проектов и задач, а также выявлять области, в которых необходимо внести улучшения.

Это связано с тем, что все члены команды смогут видеть запись совещания, что облегчает последующие действия. Кроме того, такая интеграция позволит вам отслеживать ход выполнения проектов и задач, а также выявлять области, в которых необходимо внести улучшения.

Интеграция видеосовещаний и протоколов в CRM-систему также улучшит совместную работу команды. Это связано с тем, что члены команды смогут обмениваться друг с другом записями совещаний и протоколами, что облегчит им совместную работу над проектами. Кроме того, такая интеграция облегчит членам команды возможность быть в курсе работы друг друга, например, если один из коллег вышел из строя, и кто-то другой должен его подменить.

Шаблоны протоколов заседаний

Уровень 1: простой шаблон протокола собрания

Для простых совещаний или если вам нужно дополнительное письменное дополнение к записи совещания, мы рекомендуем этот простой шаблон.

Простой шаблон протокола собрания! Нажмите на кнопку ниже, чтобы скачать его.

Скачать этот шаблон протокола собрания 👇

Хотите скачать этот шаблон? Здесь представлены все доступные форматы:

- Шаблон протокола собрания Google Sheet. Скопируйте его, чтобы перенести в свои любимые инструменты для ведения записей, такие как Notion, Evernote, Google Docs и так далее.

- Шаблон PDF (.pdf).

- Шаблон Microsoft Excel (.xlsx).

- Шаблон электронной таблицы значений, разделенных запятыми (.csv).

- Шаблон электронной таблицы OpenDocument (.ods).

Уровень 2: шаблон протокола промежуточного собрания

Этот шаблон совещания посвящен следующим шагам и тому, кто за них отвечает. Дополнительная информация, которую вы, возможно, захотите отметить, — это ожидания и сроки выполнения.

Скачать этот шаблон протокола собрания 👇

Хотите скачать этот шаблон? Здесь представлены все доступные форматы:

- Шаблон протокола собрания Google Sheet. Скопируйте его, чтобы перенести в свои любимые инструменты для ведения записей, такие как Notion, Evernote, Google Docs и так далее.

- Шаблон PDF (.pdf).

- Шаблон Microsoft Excel (.xlsx).

- Шаблон электронной таблицы значений, разделенных запятыми (.csv).

- Шаблон электронной таблицы OpenDocument (.ods).

Уровень 3: надежный шаблон протокола собрания

Если вы хотите, чтобы все было продумано до мелочей, вам стоит выбрать наш надежный шаблон протокола собрания.

Скачать этот шаблон протокола собрания 👇

Хотите скачать этот шаблон? Здесь представлены все доступные форматы:

- Шаблон протокола собрания Google Sheet. Скопируйте его, чтобы перенести в свои любимые инструменты для ведения записей, такие как Notion, Evernote, Google Docs и так далее.

- Шаблон PDF (.pdf).

- Шаблон Microsoft Excel (.xlsx).

- Шаблон электронной таблицы значений, разделенных запятыми (.csv).

- Шаблон электронной таблицы OpenDocument (.ods).

Есть причина, по которой крупные компании и корпорации традиционно всегда назначают кого-то для ведения протокола во время важных встреч: это работает.

Возможность проследить за тем, что обсуждалось, помогает всем оставаться на одной волне и сосредоточиться, устраняя риск двусмысленности и забывчивости. Красота эффективного протокола совещания заключается в последующих действиях, поэтому tl;dv функционирует как простой и асинхронный инструмент контроля для предприятий любого размера.

Если вы хотите повысить производительность и добиться лучших результатов, начните более эффективно вести протоколы на следующем собрании. И обязательно используйте такой инструмент, как tl;dv, потому что вы получите столько дополнительных преимуществ — при минимальных усилиях!

Итак… готовы к тому, чтобы вести классные протоколы совещаний?

Похожие статьи

Запись протоколов профессиональных совещаний — Видеоруководство с профессиональными советами по администрированию

Из курса: Административные профессиональные советы

Запись протоколов профессиональных совещаний

“ — Если вы являетесь специалистом по административной поддержке и отвечаете за ведение протоколов, вы можете найти способы облегчить себе работу. Поскольку информация передается быстро, а встречи проходят быстро, вам нужно убедиться, что вы вооружены набором передовых методов, которые помогут вам не сбиться с пути. Вот некоторые из лучших советов и методов, которые я изучил и применяю на протяжении многих лет. Во-первых, создайте или найдите шаблон, который вы можете использовать для сбора соответствующей информации о вашей встрече. В Интернете доступно множество шаблонов протоколов совещаний. Я создал свой собственный шаблон, который фиксирует основные моменты информации, важной для моей организации. Ваш шаблон может быть бумажным или цифровым, в зависимости от вашего комфорта и уровня навыков. Не забудьте создать свой шаблон, используя повестку дня встречи в качестве руководства. Во-вторых, физически записывайте встречи для будущего воспроизведения при составлении протокола. Я, конечно, делаю это только в том случае, если участникам удобно и приятно. Я использую портативный диктофон или приложение на своем iPhone. Эти записи очень пригодились, когда мне нужно расшифровать мои заметки или убедиться, что я точно передал информацию.

Поскольку информация передается быстро, а встречи проходят быстро, вам нужно убедиться, что вы вооружены набором передовых методов, которые помогут вам не сбиться с пути. Вот некоторые из лучших советов и методов, которые я изучил и применяю на протяжении многих лет. Во-первых, создайте или найдите шаблон, который вы можете использовать для сбора соответствующей информации о вашей встрече. В Интернете доступно множество шаблонов протоколов совещаний. Я создал свой собственный шаблон, который фиксирует основные моменты информации, важной для моей организации. Ваш шаблон может быть бумажным или цифровым, в зависимости от вашего комфорта и уровня навыков. Не забудьте создать свой шаблон, используя повестку дня встречи в качестве руководства. Во-вторых, физически записывайте встречи для будущего воспроизведения при составлении протокола. Я, конечно, делаю это только в том случае, если участникам удобно и приятно. Я использую портативный диктофон или приложение на своем iPhone. Эти записи очень пригодились, когда мне нужно расшифровать мои заметки или убедиться, что я точно передал информацию.

Это дополнительный шаг, чтобы поддерживать высокий уровень доверия к вам как к аккуратному ведущему заметок. Наконец, отправьте протокол вашей встречи как можно скорее для обратной связи и комментариев. Если вы сделаете это своевременно, у всех, кто присутствовал на собрании, все еще будет свежая память о собрании, и им не нужно будет пытаться вспомнить информацию, которая с тех пор была забыта. Как и в случае с публичными выступлениями, ведение протоколов совещаний — это то, чем вам становится удобнее, чем больше вы это делаете. Хотя временами это может быть стрессовой работой, она также позволяет вам продемонстрировать свои навыки, как лично, так и на бумаге, в отличие от других должностных обязанностей. Используйте это как возможность проявить себя, выполняя необходимую и важную работу для вашей организации.

Это дополнительный шаг, чтобы поддерживать высокий уровень доверия к вам как к аккуратному ведущему заметок. Наконец, отправьте протокол вашей встречи как можно скорее для обратной связи и комментариев. Если вы сделаете это своевременно, у всех, кто присутствовал на собрании, все еще будет свежая память о собрании, и им не нужно будет пытаться вспомнить информацию, которая с тех пор была забыта. Как и в случае с публичными выступлениями, ведение протоколов совещаний — это то, чем вам становится удобнее, чем больше вы это делаете. Хотя временами это может быть стрессовой работой, она также позволяет вам продемонстрировать свои навыки, как лично, так и на бумаге, в отличие от других должностных обязанностей. Используйте это как возможность проявить себя, выполняя необходимую и важную работу для вашей организации.Содержание

Как профессионально вести протоколы совещаний

Совещания являются частью вашего рабочего дня. Неудивительно видеть календарь, заполненный последовательными встречами в современной удаленной рабочей среде. Но это не означает, что все ваши встречи имеют одинаковое значение и влияние — на вашу личную работу и работу вашей команды. Ясно, что одни встречи более важны, чем другие, из-за влияния решений, принятых в результате обсуждений.

Неудивительно видеть календарь, заполненный последовательными встречами в современной удаленной рабочей среде. Но это не означает, что все ваши встречи имеют одинаковое значение и влияние — на вашу личную работу и работу вашей команды. Ясно, что одни встречи более важны, чем другие, из-за влияния решений, принятых в результате обсуждений.

Когда собрание важное, скажем, заседание совета директоров, естественно, вы захотите вести протокол собрания, чтобы задокументировать обсуждение и зафиксировать решения и действия. Но нет единственно правильного способа вести протокол собрания.

В этой статье мы поможем вам узнать, как лучше всего вести протокол заседания совета директоров или любого другого собрания , не теряя важных деталей и контекста.

Итак, приступим.

Что такое протокол встречи?

Начнем с основ.

Удивительно, но «минуты» встречи не относятся к минуте, измерению времени. Оно переводится как «маленький», как «минутка» (мой-тритон). Другими словами, сжатые, небольшие заметки, сделанные во время встречи. Это должно прояснить некоторые вопросы, в том числе — должен ли я фиксировать каждую минуту встречи (нет) и какой идеальный формат для протокола встречи (небольшие заметки, а не сложные).

Другими словами, сжатые, небольшие заметки, сделанные во время встречи. Это должно прояснить некоторые вопросы, в том числе — должен ли я фиксировать каждую минуту встречи (нет) и какой идеальный формат для протокола встречи (небольшие заметки, а не сложные).

Протоколы собраний служат единым источником достоверной информации для будущих ссылок. Он должен отражать обсуждения, решения, действия и последующие шаги.

Протокол собрания и заметки о собрании

Заметки о собрании используются для записи всего, что вы хотели бы запомнить после окончания собрания. Это не официальный документ (который должен быть рассмотрен и подписан вашим руководителем) и не предназначен для использования в качестве фактического источника встречи. Вы не можете использовать заметки о собрании в юридических целях.

С другой стороны, «протокол собрания» — это обычно официальная документация того, что произошло во время собрания. В нем не должно быть ваших идей, заметок, отзывов или каких-либо личных мнений. Он должен отражать обсуждения и решения без какой-либо предвзятости или дополнений.

В нем не должно быть ваших идей, заметок, отзывов или каких-либо личных мнений. Он должен отражать обсуждения и решения без какой-либо предвзятости или дополнений.

Например, заседания совета директоров, как правило, имеют протокол, который может служить юридическим документом о том, что произошло. Если вы считаете, что вам нужно делать заметки о встречах, а не формальные протоколы, перейдите к руководству о том, как лучше делать заметки о встречах.

Зачем вести протокол собрания?

. Протокол собрания предназначен для совместного использования с другими. Таким образом, это гарантирует, что все в курсе того, что обсуждалось, какие решения были приняты и какие конкретно для них следующие шаги. Это приносит ответственность на ваши встречи.

. Запись обсуждений, решений и последующих шагов может превратить ваши эфемерные встречи в хранилище знаний.

— Вы всегда можете вернуться в прошлое и посмотреть, как вы или ваша команда выполнили планы и что можно улучшить.

— Все на одной странице. Даже если кто-то не смог присутствовать на совещании, протокол собрания может помочь им быстро наверстать упущенное и набрать скорость.

Шаблоны протоколов собраний

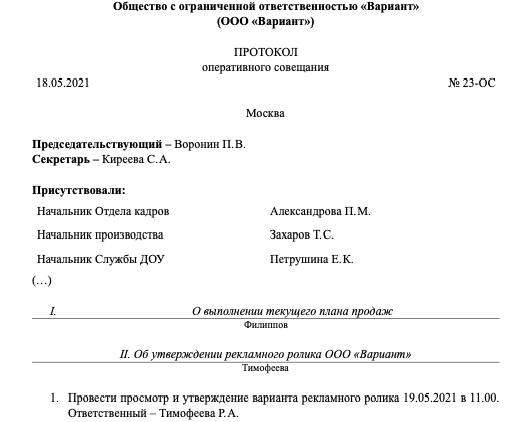

Каждый протокол собрания должен содержать следующее:

- Дата и время собрания,

- Полные имена участников (включая тех, кто не смог присутствовать),

- Повестка дня и темы для обсуждения,

- Действия и последующие действия.

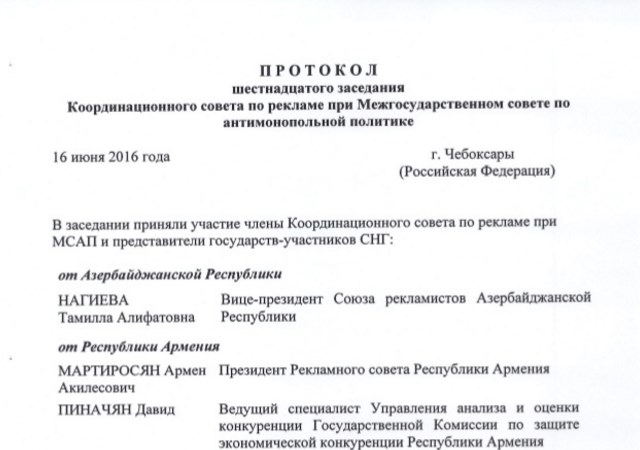

Если собрание носит официальный характер, то вы должны указать вступительные слова, дополнения к повестке дня, принятые или отклоненные предложения и время перерыва.

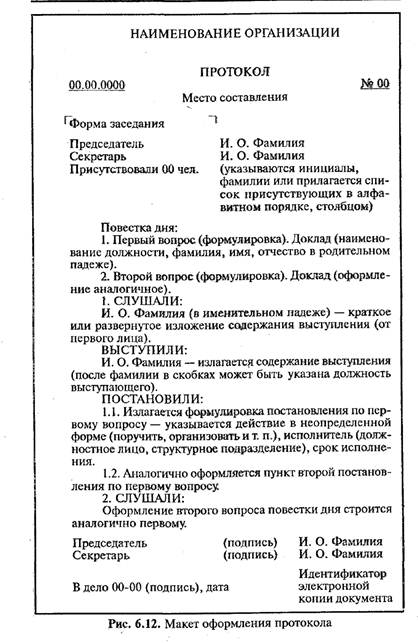

Вот пример протокола неформальной встречи.

Дата: ММ/ДД/ГГГГ

Участники:

- Список участников

Идеи программы:

- Пункт 1

- Пункт 2

- Пункт 3

Ключевые решения:

- Решение 1,

- Решение 2 ,

- Решение 3.

Следующие шаги:

- Перечислите следующие шаги, которые должны быть предприняты участниками или непосредственными ответственными лицами (DRI) собрания.

- Действия.

Как вести протокол собрания

Прежде чем мы углубимся:

. Эта статья написана в первую очередь для тех из нас, кто проводит собрания Zoom. Количество ежегодных протоколов собраний в Zoom превысило 3,3 триллиона! Мы потратили много времени на Zoom и будем продолжать. Таким образом, можно с уверенностью сказать, что вы полагаетесь на Zoom и для своих встреч.

. Мы расскажем вам, как эффективно вести протоколы совещаний и делиться ими. Никаких передовых практик, только действенные шаги. Не стесняйтесь присоединяться и пробовать что-то, пока мы переходим от одного шага к другому.

— Мы будем использовать Grain — инструмент, который позволит вам делать заметки с отметками времени, фиксировать и делиться важными моментами совещаний Zoom. Это бесплатно для начала, и вы можете обновить в зависимости от вашего использования. Убедитесь, что вы зарегистрировались и загрузили настольное приложение.

Это бесплатно для начала, и вы можете обновить в зависимости от вашего использования. Убедитесь, что вы зарегистрировались и загрузили настольное приложение.

Шаги к эффективно вести протокол собрания :

- Запишите важные детали.

- Используйте повестку собрания.

- Задокументируйте ключевые моменты.

- Запечатлейте основные моменты и решения.

- Назначить действия.

- Уточните свои пункты.

- Делайте записи точными.

- Проверка и очистка.

- Поделитесь записью, основными моментами и сводкой.

- Сохрани знания.

Перед собранием

1. Запишите основные сведения:

Вы должны вести запись основных сведений, включая дату и время собрания, место, цель и участников. Просто взглянув на свой Календарь Google, вы получите всю информацию, которая вам, скорее всего, понадобится.

Кроме , Зерно может помочь вам со всеми деталями. Вы можете увидеть цель собрания (из названия собрания), дату и время собрания (данные «Записано») и участников собрания (из «Люди в этой записи»).

Вы можете увидеть цель собрания (из названия собрания), дату и время собрания (данные «Записано») и участников собрания (из «Люди в этой записи»).

2. Используйте Повестку дня:

Заранее ознакомьтесь с повесткой дня, чтобы подготовиться к встрече. Повестка дня может дать вам схему/структуру протокола встречи и гарантировать, что вы не пропустите ничего важного во время встречи.

Повестка собрания также может быть частью протокола собрания. Например, вы можете включить пункты повестки дня собрания и добавить последующую работу или решения.

Во время встречи

3. Задокументируйте важные моменты:

Использование настольного приложения Grain — это самый эффективный способ делать заметки о встрече с отметками времени, которые непосредственно соответствуют вашей записи и стенограмма.

После того, как вы загрузите приложение и синхронизируете его с календарем, Grain автоматически появится при начале собрания, просто нажмите «Запись».

При записи с помощью Grain у вас будет блокнот, чтобы вы могли комментировать встречу в режиме реального времени. Обращайте внимание на обсуждение и отмечайте важные моменты, записывая строчкой или используя #теги.

Все ваши аннотации будут превращены в общие клипы.

Совет: Grain предлагает блокнот для совместной работы в реальном времени. Таким образом, вы также можете пригласить одного из членов вашей команды делать заметки вместе с вами.

4. Решения о захвате:

Если предстоит принять важное решение, превратите момент в общий клип за считанные секунды во время или после встречи. Как?

Запишите важную информацию в блокноте «Зерно» (например, «в этом квартале вы планируете инвестировать 50 000 долларов США в маркетинговые мероприятия»), а затем щелкните значок «Выделить» в блокноте. Вот и все! У вас будет клип, которым теперь можно поделиться в Slack, Notion или любых других рабочих инструментах, которые вы используете.

5. Назначить Действия:

Всякий раз, когда появляется пункт действия, убедитесь, что вы знаете, кто несет ответственность за его выполнение. Назначение элемента конкретному лицу гарантирует, что работа будет выполнена и не будет остановлена после обсуждения.

Просто укажите человека/владельца и задачу вместе с крайним сроком.

6. Уточнить:

Поскольку здесь вы делаете заметки, важно получить полный контекст для каждого решения и действия. Например, если у пункта действия нет исполнителя или решение не имеет полного контекста, убедитесь, что вы поднимаете этот вопрос во время собрания.

7. Будьте точны:

Grain записывает и расшифровывает ваши встречи по мере их проведения и загружает их в рабочую область Grain. Таким образом, у вас есть запись того, что произошло, и вы можете пересмотреть ее в любое время, если это необходимо. Делая заметки, старайтесь говорить прямо и просто. Не уточняйте и не пишите абзацами.

Не уточняйте и не пишите абзацами.

После собрания

8. Просмотр и очистка:

Как только собрание закончится, перейдите в рабочее пространство Grain и получите доступ к записи. Просмотрите свои заметки, клипы и при необходимости внесите изменения.

Вы также можете создавать новые клипы , выбрав стенограмму и нажав «Создать выделение».

После того, как вы внесли правки и создали необходимые блики, при необходимости получите одобрение у вашего менеджера.

9. Поделитесь со своей командой:

Следующим шагом будет поделиться протоколом собрания со своей командой.

Поскольку вы уже знаете основные детали, такие как имена участников, повестка дня собрания, время и дата и т. д., остается только включить решения и действия.

Когда вы используете Grain, вы, по сути, фиксируете решения и ключевые моменты во время встречи, и они будут готовы поделиться ими в предпочитаемом вами формате: список основных моментов или видеорезюме.

— Основные моменты:

Вы можете поделиться всеми клипами лучших моментов, которые вы создали во время встречи, просто нажав «Копировать основные моменты».

Это поможет вам поделиться решениями и ключевыми моментами вашей встречи, и самое приятное то, что ваша команда/участники могут пересмотреть ключевой момент, если им понадобится дополнительный контекст.

— Резюме видео:

Вы можете создать краткое видеообзор встречи , состоящее из клипов важных моментов, а затем поделиться им с другими.

Перейдите на страницы «Истории» > нажмите «Новая история» > «Добавить новые разделы» (чтобы сгруппировать клипы с лучшими моментами) > «Добавить новые основные моменты». После этого просто поделитесь URL-адресом истории.

Получатель может видеть барабан лучших моментов, воспроизводимых в формате Story. В Grain Story будут и видеоклипы, и заметки, связанные с клипами.

После того, как вы решите, чем хотите поделиться (записью, списком основных моментов или сводкой видео), вы можете включить то же самое в документ или электронное письмо с протоколом собрания. Вуаля!

Вуаля!

Хотите поделиться всей записью?

Если вы хотите поделиться всей записью, просто нажмите «Поделиться» и введите адрес электронной почты.

Если вы хотите поделиться своими записями со всей командой, добавьте свою команду в рабочую область «Зерно» и включите переключатель. Это сэкономит вам массу времени, и таким образом вы сможете автоматически делиться записями со своей командой, как только встреча закончится.

Источник: GrainКроме того, вы можете использовать другие инструменты для протоколов совещаний, чтобы поделиться протоколами с остальной частью вашей команды.

10. Сохраните знания:

После того, как вы поделитесь протоколом собрания, вам необходимо сохранить его в облаке для дальнейшего использования. С Grain это происходит автоматически.

Все записи ваших совещаний будут расшифрованы и сохранены вместе с заметками о собраниях и клипами с лучшими моментами.